Apache Sqoop

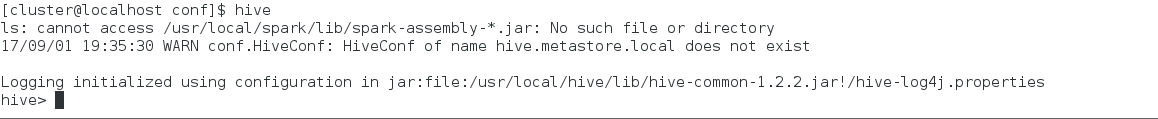

Bueno, hasta este punto ya tenemos una instancia de Apache Hadoop con YARN configurado y una instancia de Apache Hive, lo siguiente será dar un poco de contexto de lo que es Apache Sqoop.

Apache Sqoop es una herramienta para la transferencia de grandes volúmenes de información entre Apache Hadoop y las RDBMS ó Mainframes. Cómo sabrán Apache Sqoop necesita de una Instancia de Apache Hadoop al menos para poder funcionar, ya que es un MapReduce.

Dependiendo del número de nodos en el clúster, se crearán n pools de conexión donde n es el número de nodos en el clúster para extraer la información.

El flujo general de un Job del tipo Sqoop que es un MapReduce, luciría como el siguiente.

Apache Sqoop puede ser utilizado para hacer transferencia de grandes volúmenes de Datos de Bases de Datos Relacionales a HDFS ó de viceversa.

Para ejemplificar de que manera trabaja un Job como Apache Sqoop lo ejemplificaré con dos de sus acciones principales, el export e import

Import: Como vemos en la siguiente imagen, existe un origen con nombre DB donde cabe resaltar que DB puede ser (Oracle, MySQL, SQLServer, Informix, etc), como podemos notar, Apache Sqoop crea un pool de conexión por nodo y lleva a cabo un proceso Map para extraer la información y depositarlo en HDFS.

Export: Como vemos en la siguiente imagen, existe un origen con nombre DB donde cabe resaltar que DB puede ser (Oracle, MySQL, SQLServer, Informix, etc), como podemos notar, Apache Sqoop crea un pool de conexión por nodo y lleva a cabo un proceso Map para insertar la información en HDFS y almacenarla en una RDBMS.

Como podemos ver, Apache Sqoop solo es una implementación de un proceso MapReduce, donde solo tiene implementado el Mapper. Este componente es muy útil cuando se trata de extraer información de RDBMS a toda la infraestructura de Hadoop.

Como conclusión a este punto del Blog ya podemos crear una herramienta como sqoop con nuestro propio código, pero, ¿Para que codificar algo que ya esta?, Sqoop es la primera herramienta para extracción y almacenamiento entre Hadoop y RDBMS.

Apache Sqoop es una herramienta para la transferencia de grandes volúmenes de información entre Apache Hadoop y las RDBMS ó Mainframes. Cómo sabrán Apache Sqoop necesita de una Instancia de Apache Hadoop al menos para poder funcionar, ya que es un MapReduce.

Dependiendo del número de nodos en el clúster, se crearán n pools de conexión donde n es el número de nodos en el clúster para extraer la información.

El flujo general de un Job del tipo Sqoop que es un MapReduce, luciría como el siguiente.

Apache Sqoop puede ser utilizado para hacer transferencia de grandes volúmenes de Datos de Bases de Datos Relacionales a HDFS ó de viceversa.

Para ejemplificar de que manera trabaja un Job como Apache Sqoop lo ejemplificaré con dos de sus acciones principales, el export e import

Import: Como vemos en la siguiente imagen, existe un origen con nombre DB donde cabe resaltar que DB puede ser (Oracle, MySQL, SQLServer, Informix, etc), como podemos notar, Apache Sqoop crea un pool de conexión por nodo y lleva a cabo un proceso Map para extraer la información y depositarlo en HDFS.

Export: Como vemos en la siguiente imagen, existe un origen con nombre DB donde cabe resaltar que DB puede ser (Oracle, MySQL, SQLServer, Informix, etc), como podemos notar, Apache Sqoop crea un pool de conexión por nodo y lleva a cabo un proceso Map para insertar la información en HDFS y almacenarla en una RDBMS.

Como podemos ver, Apache Sqoop solo es una implementación de un proceso MapReduce, donde solo tiene implementado el Mapper. Este componente es muy útil cuando se trata de extraer información de RDBMS a toda la infraestructura de Hadoop.

Como conclusión a este punto del Blog ya podemos crear una herramienta como sqoop con nuestro propio código, pero, ¿Para que codificar algo que ya esta?, Sqoop es la primera herramienta para extracción y almacenamiento entre Hadoop y RDBMS.

Comentarios

Publicar un comentario