Apache Hadoop Manejo

Bueno después de la teoría y la instalación sigue un poco de práctica para saber como manejar la herramienta que acabamos de instalar.

El último post se quedo mostrando la página inicial de la interfaz web de hadoop, hoy explicaremos acerca de esta y algunos comandos para la utilización de esta herramienta que hemos instalado.

Como podemos ver en la Imagen esta es la página Inicial y principal, en el recuadro rojo podemos ver la versión de hadoop que hemos instalado la 2.8.0 en nuestro caso y también podemos ver la fecha en que se compilo este binario y algunas características más que son fáciles de entender por el nombre.

Esta página nos muestra información del conjunto de datanodes existentes en nuestro clúster, espacio de memoria disponible la última vez que el namenode se comunico con los datanodes, información del host.

En caso de que hubiera errores con el medio de almacenamiento de los datanodes esta página nos mostraría detalle de esas fallas.

Esta Imagen nos muestra un recuento del proceso de levantamiento de hadoop.

En la pestaña Utilities el nos despliega dos opciones, una es Browse the File System y logs.

Si seleccionamos la opción de logs nos redireccionará a una página como la siguiente. En donde podremos encontrar información acerca de los datanodes que tenga nuestro clúster, namenodes y secondary namenodes.

Y una de las partes más importantes de este explorador es esta parte el Browse Directory, que es la parte visual que nos deja visualizar la información que tenemos montada en nuestro HDFS de una forma gráfica y normal para nosotros que estamos acostumbrados a ver la información de forma física y bonita.

En la anterior imagen, no tenemos ninguna información en nuestro HDFS, es verdad cuando te dicen que Big Data almacena cualquier tipo de información y puedes procesar cualquier tipo de información, lo que no te dicen es que debes saber como para hacer eso, ya que las herramientas hoy en día para Big Data son limitadas o exclusivas de grandes empresas.

Hadoop como en la parte de teoría vimos provee un conjunto de comandos para interactuar con esta herramienta. Los dos principales comandos que provee hadoop para el manejo de si mismo son:

El último post se quedo mostrando la página inicial de la interfaz web de hadoop, hoy explicaremos acerca de esta y algunos comandos para la utilización de esta herramienta que hemos instalado.

Como podemos ver en la Imagen esta es la página Inicial y principal, en el recuadro rojo podemos ver la versión de hadoop que hemos instalado la 2.8.0 en nuestro caso y también podemos ver la fecha en que se compilo este binario y algunas características más que son fáciles de entender por el nombre.

Esta página nos muestra información del conjunto de datanodes existentes en nuestro clúster, espacio de memoria disponible la última vez que el namenode se comunico con los datanodes, información del host.

En caso de que hubiera errores con el medio de almacenamiento de los datanodes esta página nos mostraría detalle de esas fallas.

Esta Imagen nos muestra un recuento del proceso de levantamiento de hadoop.

En la pestaña Utilities el nos despliega dos opciones, una es Browse the File System y logs.

Si seleccionamos la opción de logs nos redireccionará a una página como la siguiente. En donde podremos encontrar información acerca de los datanodes que tenga nuestro clúster, namenodes y secondary namenodes.

Y una de las partes más importantes de este explorador es esta parte el Browse Directory, que es la parte visual que nos deja visualizar la información que tenemos montada en nuestro HDFS de una forma gráfica y normal para nosotros que estamos acostumbrados a ver la información de forma física y bonita.

En la anterior imagen, no tenemos ninguna información en nuestro HDFS, es verdad cuando te dicen que Big Data almacena cualquier tipo de información y puedes procesar cualquier tipo de información, lo que no te dicen es que debes saber como para hacer eso, ya que las herramientas hoy en día para Big Data son limitadas o exclusivas de grandes empresas.

Hadoop como en la parte de teoría vimos provee un conjunto de comandos para interactuar con esta herramienta. Los dos principales comandos que provee hadoop para el manejo de si mismo son:

- hadoop

- hdfs

El comando hadoop es el conjunto universo de comandos en hadoop, ya que nos provee comandos para controlar los siguientes tipos de File Systems (Local FS, HFTP FS, S3 FS, and others) entre ellos el hdfs.

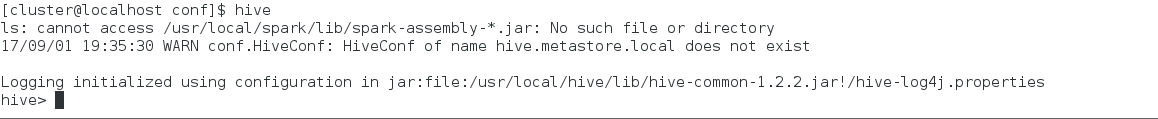

Si en una shell de nuestro linux escribimos hadoop --help (-help) nos mostrará lo siguiente:

Algunos Comando a su ves son árboles también y con la siguiente estructura podemos obtener una descripción de lo que hace cada uno hadoop command --help lo ejemplificaré con el siguiente comando hadoop fs --help (-help).

Como pueden ver pueden ir investigando combinación por combinación de comandos en su casa, el último comando ejemplo antes de pasar a la carga de archivos y manejo del HDFS, les mostraré por que el comando hadoop es más general que el comando hdfs, al usar el siguiente comando hadoop dfs --help obtendremos la siguiente traza donde podemos ver que en esta versión de hadoop, nos dice que esta funcionalidad esta deprecada, pero podemos seguir usándola, y nos sugiere que en su lugar usemos el comando hdfs dfs --help.

Bueno después de esto, el propósito de este manual de uso, es el de conocer como funciona el sistema de archivos de hadoop, y para eso nuestro mejor amigo se volverá el Browse Directory.

Como les mostré anteriormente nuestro Browse Directory no tiene nada de información, para este ejemplo subiré archivos que tenga a la mano, pero el procesamiento sirve para cualquier tipo de archivo.

En esta parte estaremos trabajando con dos File Sytem al mismo tiempo, nuestro File System Local y HDFS.

Para este ejemplo tenemos archivos (pdf, jpg, pptx) cabe aclarar que los comandos siguientes sirven para cualquier tipo de archivo, pero estos son los que yo tengo disponibles.

Comenzaremos por crear una carpeta en HDFS.

En una consola de linux escribimos el siguiente comando.

hdfs dfs -mkdir /carpetaBlog

Una vez que termine de ejecutarse nos vamos al explorador y en la página de Browse Directory podremos visualizar la carpeta que acabamos de crear en el File System de Hadoop (HDFS).

Ahora subiremos los archivos anteriormente listados a esta carpeta que acabamos de crear en HDFS.

Para eso procederé a mover todos los archivos de mi File System Local que estan en Desktop a una carpeta y luego subiré todos los archivos de esa carpeta de mi File System Local a HDFS.

El comando hdfs dfs -copyFromLocal pathFileSystemLocal pathHDFS nos ayuda a mover archivos de nuestro File System Local a HDFS como vemos en el ejemplo anterior. En el explorador ahora podemos ver los archivos dentro de esa carpeta.

El sistema de comandos de hadoop es muy parecido al de linux, así que si manejas linux no te costará trabajo navegar, crear, subir, bajar, dar permisos etc, a todo el sistema de archivos de hadoop (HDFS).

No explicaré todos los comandos por que si no esta guía sería inmensa, pero con lo anterior puedes ir investigando que hace cada comando, otra cosa por resaltar es que cuando seleccionas un archivo que vive en HDFS, el te da algunas características que ya explique en el apartado de Teoría.

Solo explicaré la característica de Availability que nos dice que nodos tienen este bloque en el clúster, como nuestro clúster solo tiene un nodo y la propiedad de replicación fue de uno, por eso solo nos sale el localhost.

Comentarios

Publicar un comentario